Menos datos y más respuestas

Escrito por: Jorge González

Todo negocio se basa en una apuesta sobre el comportamiento humano. Las marcas que mejores resultados alcanzan, son las que mejor comprenden a sus clientes y, por tanto, pueden adelantarse a sus necesidades.

Sin lugar a dudas la capacidad actual de captura, análisis y uso de grandes volúmenes de información no tiene precedentes. Tanto es así que algunos autores han llegado a comparar la vorágine incontenible de datos que producimos todos con un sistema nervioso global, y otros -en términos algo más crematísticos- consideran a los datos como el petróleo de la era digital. Y no es para menos. De las diez empresas cotizadas con mayor valor de mercado del planeta, cinco (Alphabet, Amazon, Microsoft, Facebook y Tencent) basan gran parte de su modelo de negocio en este nuevo crudo.

Internet y los teléfonos inteligentes, han hecho de nuestros datos una mercancía abundante, omnipresente y cada vez más valiosa. Ya estemos dándonos un paseo, navegando por internet, o trasteando con una aplicación, estamos dejando (queriendo, o sin querer) un rastro inmediatamente incorporable a la destilería digital de turno. Con la progresiva incorporación de todo tipo de productos a internet y la sofisticación de los algoritmos de inteligencia artificial para aprender autónomamente, nuestros datos, no sólo incrementan su valor, sino que se espera que puedan desde predecir cuándo vamos a realizar nuestra próxima compra, hasta prevenir que suframos un infarto, pasando, obviamente, por ofrecernos una experiencia de cliente espectacular.

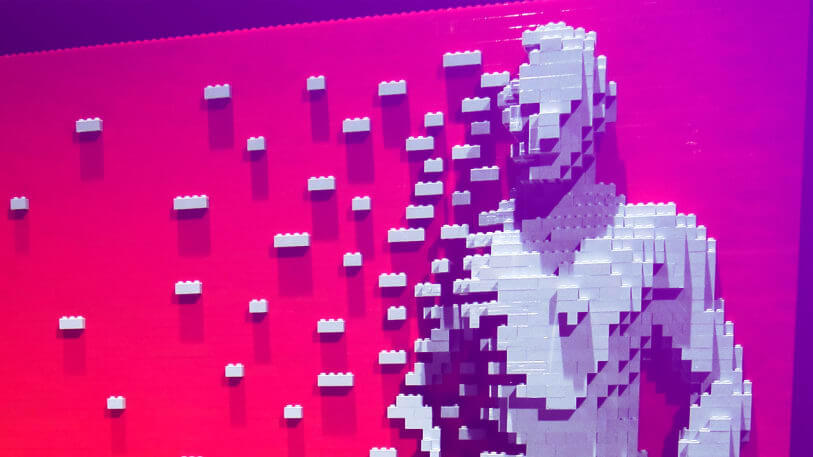

Bonitas promesas. Escuchadas hasta la saciedad en la feria de transformación digital Digital Business World Congress, celebrada en Madrid los pasados 23, 24 y 25 de mayo y a la que acudí gracias a una invitación de IBM. Pero creo que precisan de alguna que otra puntualización.

En el artículo de hoy, para no extenderme mucho, voy a destacar un par (de entre las muchas que podrían plantearse). Los grandes volúmenes de datos, el aprendizaje automático y la analítica, trabajan desvelando correlaciones, no causas. Son extraordinariamente eficaces para establecer relaciones estadísticamente significativas entre variables, pero son absolutamente incapaces de ofrecer la menor pista sobre el porqué de las mismas. Información sin explicaciones. Aprendizaje sin comprensión.

La primera de ellas es la falsa idea de que los números hablan por sí solos, muy difundida en el ámbito tecnológico y respaldada por artículos mitológicos como “The End of theory”, publicado a principios del verano del 2008 en la revista Wired, por su, por aquel entonces redactor jefe, Chris Anderson:

“Este es un mundo en el que cantidades masivas de datos y matemática aplicada reemplazan a cualquier otra herramienta. Despidámonos de todas las teorías sobre el comportamiento humano, desde la lingüística, hasta la sociología. Olvidémonos de la taxonomía, la ontología y la psicología. ¿Quién quiere saber por qué las personas hacen lo que hacen? La cuestión es que lo hacen. Y lo podemos monitorizar y medir con un nivel de fidelidad inusitado. Con datos suficientes, los números hablan por sí mismos.”

Mucho antes de Google nos hiciera la vida más fácil con su buscador, Facebook nos atontara con sus noticias falsas y Amazon nos emplazara a comprar (casi) cualquier cosa y en cualquier momento con unas pocas pulsaciones, una persona con unos conocimientos mínimos de estadística era consciente de las limitaciones de entender el mundo a través de datos. Valga como ejemplo el célebre super sondeo electoral que catapultó engorrosamente a la ignominia a la hasta entonces respetada publicación norteamericana The Literary Digest en 1936. En aquel año, marcado por el fin de la Gran Depresión, el que fuera gobernador de Kansas, Alfred Landon, se presentó a las elecciones presidenciales representando al partido republicano contra el presidente Franklin D. Roosevelt. El magazine, se comprometió a pronosticar el resultado, labor que cumplió a través de una encuesta de opinión postal de dimensiones bíblicas, con la intención de llegar hasta 10 millones de estadounidenses, un cuarto del electorado.

Tras dos meses de comprobar por triplicado, verificar, realizar cinco clasificaciones cruzadas y totalizar los 2,4 millones de respuestas recibidas, el Digest, que desde 1916 había pronosticado correctamente los resultados electorales norteamericanos, concluyó que Landon ganaría las elecciones con un amplio margen de 14 puntos porcentuales (55% frente a 41%).

La realidad arrojó unas cifras sensiblemente distintas: Roosevelt fulminó a Landon consiguiendo el 61% de los votos, frente al 37% alcanzado por este último.

Para más inri, un estudio de dimensiones muchísimo más modestas (entre 3.000 y 50.000 personas, según la fuente), realizado por George Gallup, pionero en estudios de opinión y medición de audiencias, pronosticó un resultado final mucho más próximo al real que el pronosticado por el Digest. Mi tocayo comprendió algo que los responsables del sondeo del Digest no: cuando se trata de datos, el tamaño no es lo más importante.

Los sondeos de opinión se basan en muestras generales de población con derecho a voto, lo que implica prestar atención a tres asuntos críticos: el error muestral, el sesgo de selección y el sesgo de no respuesta.

El error muestral pone en evidencia el riesgo de que, por mera casualidad, la elección de la muestra aleatoriamente seleccionada, no refleje fielmente las opiniones de la población objeto de estudio. El margen de error, o nivel de confianza, refleja este riesgo, y en teoría, cuanto mayor sea la muestra, menor debería ser el error muestral.

En teoría, pues al error muestral hay que sumarle otro compinche: el sesgo de selección, que sucede cuando la muestra no se selecciona correctamente de manera aleatoria. Motivo por el cual a quienes nos dedicamos a la investigación, nos preocupa y nos cuesta mucho más confeccionar una muestra representativa, que una muestra de gran tamaño.

El principal error del Digest consistió en extraer los datos de listas de ciudadanos que figuraban en directorios telefónicos (en 1936 tener un teléfono era un lujo), membresías de clubs y asociaciones automovilísticas. Una muestra claramente sesgada hacia el votante de clase media y alta. Para echar más leña al fuego, los partidarios de Landon, resultaron ser más propensos a responder que los de Roosevelt.

El segundo error, se debió a la escasez relativa de respuestas recibidas. De los 10 millones de encuestas enviadas, “solo” se recibieron 2.4 millones de respuestas. Teniendo en cuenta que las personas que responden a las encuestas tienen un perfil claramente distinto de las que no, ya tenemos la tormenta perfecta.

A pesar de que este desastre propició un refinamiento sustancial de las técnicas para sondear la opinión pública, hoy estamos repitiendo los errores del pasado por culpa de esa ficción tecnoutópica que nos lleva a creer que los números hablan por sí solos. Trump y el Brexit en política, la dificultad para seleccionar mejores carteras de inversión en finanzas y los constantes fracasos en el lanzamiento de productos y servicios al mercado, son sólo algunos de los muchos ejemplos de lo poco que hemos aprendido en los últimos años sobre la interpretación correcta de la información.

No quisiera cerrar el artículo de hoy, sin una breve segunda puntualización para reprobar esa creciente actitud cientificista del mundo de los negocios por pretender cuantificarlo todo. Es un espejismo. No se puede. Ni se debe.

En primer lugar, porque los negocios no son ciencias naturales, ni mucho menos exactas; son ciencias sociales. Como nos recuerda el astrofísico Neil deGrasse Tyson, “En ciencia, cuando el comportamiento humano irrumpe en la ecuación, las cosas se vuelven no lineales. Por eso la física es fácil y la sociología es difícil”.

En segundo lugar, porque, como apunté al principio, ni las mejores técnicas analíticas, ni los algoritmos de aprendizaje automático más sofisticados, han sido, son, ni van a ser capaces de dar respuesta al problema que más quebraderos de cabeza ha ocasionado a los estadísticos durante siglos: el porqué de las cosas, de inferir qué es lo que está pasando y averiguar cómo intervenir para modificar algo y hacerlo mejor. La interpretación de la información es una competencia humana que no podrá ser automatizada en todos los ámbitos por su dificultad para contextualizarla adecuadamente.

Finalmente, y para que quede claro que no soy ningún seguidor de Ned Ludd, ni pretendo desestimar los avances tecnológicos en mi vida privada, ni mucho menos en mis obligaciones profesionales (que me estés leyendo se debe en parte a los algoritmos de Google), liquidaré el presente artículo recordando que, a la hora de innovar, no disponemos de datos sobre el mañana, y extrapolar información pretérita en el futuro es una manera segura de anclarnos en el pasado.

En definitiva, el arte del management siempre ha consistido en tomar decisiones a partir de información inconclusa, imperfecta y a menudo incómoda. Y así será… hasta que la singularidad nos alcance.